Странно, что никто не отписался в теме, уж слишком явные вылезли несостыковки. После некоторого перерыва я посмотрел разные книжки/лекции/статьи, и вот что уяснил (надеюсь, что меня поправят, если я не прав, либо добавят свое видение).

1. Область значений оценки не обязана совпадать с областью значений оцениваемой параметрической функции. Об этом написано в Леман Э., "Теория точечного оценивания". Там сказано, что "удобно не накладывать это ограничение". Видимо это делается для теоретических выкладок и доказательств. Вообще такого требования я в книжках почти не встречал. Так что можно совершенно спокойно (это даже очень удобно) вводить статистическую модель

при

и рассматривать статистику

.

2. Далее насчет определения оценки ОМП. В лекциях MIT (

http://ocw.mit.edu/courses/mathematics/ ... ure-notes/) я обнаружил более аккуратное, на мой взгляд, определение:

3.1 Maximum Likelihood Estimates - In Exponential Families писал(а):

Let

be a measurable space and

a measurable family of laws on

, dominated by a

-finite measure

. Let

be a jointly measurable version of the density

by Theorem 1.3.3. For each

, a maximum likelihood estimate (MLE) of

is any

such that

. In other words,

is a point at which

attains its maximum. In general, the supremum may not be attained, or it may be attained at more than one point. If it is attained at a unique point

,then

is called the maximum likelihood estimate of

. A measurable function

defined on a measurable subset

of

is called a maximum likelihood estimator if for all

,

is a maximum likelihood estimate of

, and for

-almost all

not in

, the supremum of

is not attained at any point.

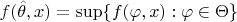

Ну т.е. главное, чтобы на каком-нибудь измеримом множестве иксов супремум на параметрическом множестве достигался, тогда на этом множестве полученная оценка и называется ОМП. Далее неоднократно подчеркивается, что супремум для каких-то иксов может в общем случае не достигаться, в том числе и для распределений экспоненциальных семейств.

3. Далее, в теореме про асимптотические свойства ОМП есть такое условие:

3.8 Efficiency of maximum likelihood estimators писал(а):

(EML-3)

is a sequence of maximum likelihood estimators and is consistent, in other words

in

-probability as

for all

.

Здесь речь идет именно об ОМП, которая для

при

не существует при

и

, но существует для всех других иксов. Впрочем, это не страшно, так как вероятность попадания в эти два "особенных" случая стремится к нулю при

и на асимптотические свойства повлиять потому не может.