Суть проблемы

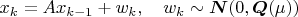

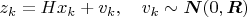

Наблюдаем в дискретном времени случайный процесс:

Наблюдаем вот так:

У

корреляционная матрица

зависит от одного скалярного параметра. Он неизвестен.

И я с помощью банка фильтров Калмана, настроеных на дискретный набор значений параметра

пытаюсь оценить, чему равен этот параметр, для чего для каждого фильтра Калмана вычисляется логарифм функции правдоподобия. Оценка параметра берется по максимуму логарифма функции правдоподобия среди всех фильтров.

Можно ли посчитать ошибку оценки параметра как-то еще помимо моделирования Монте-Карло, которое достаточно медленно сходится? По Монте-Карло я считаю.