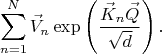

В трансформерах механизм "внимания" реализован через подсчёт суммы

Как я уже писал об этом в другой теме (

https://dxdy.ru/post1707690.html#p1707690) в подобной сумме для того чтобы не произошло чрезмерного усреднения по всем слагаемым нужно чтобы норма ключевых векторов была не меньше чем некий порог зависящий от логарифма от

:

А теперь представьте что происходит в LLM трансформере при длинном контексте

. Вот оно начало читать/писать текст, сначала

маленькое, потом

становится всё больше и больше. Ключи которые были вычислены в начале когда

было маленьким - это одно, а ключи которые были вычислены потом когда

стало большим - это совсем другое. Довольно понятно, что более поздние ключи (посчитанные когда

уже стало большим) вероятнее всего будут длиннее более ранних ключей (когда

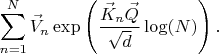

было ещё маленьким). Поскольку ранние ключи короче поздних ключей, то и "внимание" к раннему тексту "уделяется" всё меньше и меньше. По идее, такой трансформер с "логарифмическим весом" забывает то, что было написано в начале. Ну, мне так кажется. Экспериментально проверить не могу. Не обладаю технической возможностью. Но если это действительно так, то довольно понятно как можно было бы спасти трансформер от логарифмического забывания контекста. Похоже, что вот такая модификация "внимания" должна была бы помочь:

Нужно просто добавить

в экспоненту, тогда норма ключевых векторов не будет зависеть от длины контекста.