B@R5ukВы правы. Глобальный минимум выглядит так:

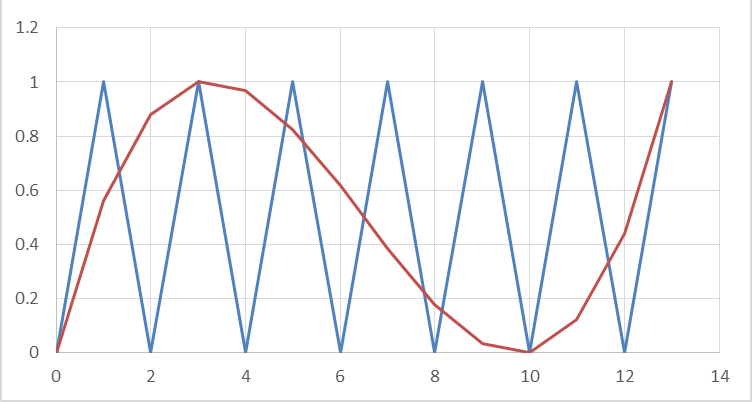

Пришлось перебрать все полиномы, чтобы в этом убедиться (с условием, что они центрально симметричны, их всего 21). А градиентный спуск как-то все проезжает мимо этого минимума. Приводит к нему, но едет дальше. Видимо, там очень мелкая ямка.

ozheredovЭто же наверное стандартная задача. Дан ряд реализаций случайной величины, подобрать параметры плотности вероятности известного вида для этого ряда. Скажем, подобрать такие параметры плотности вероятности, чтобы произведение вероятностей всех реализаций стало максимальным. Точнее, произведение соответствующих значений кривой плотности вероятности для этих реализаций. И наоборот: дана плотность вероятности известного вида, "подобрать под нее" параметры случайного ряда (в данном случае это параметры регрессионной кривой). Считается, что шум во всех точках данных подчиняется одному и тому же распределению, независимому от данных, которое нам известно.

А иногда о нем даже не все нужно знать. Скажем, для нормального распределения не нужно знать дисперсию. Достаточно того, что она постоянна. А вот с равномерным распределением я поторопился, наверное. Максимум, что там можно сделать, это прибавть к регрессионной кривой сверху и снизу полосы пределов этого распределения и следить за тем, чтобы все точки данных вошли в эти полосы. Вычислять там нечего.